Краулинговый бюджет, который мы узнаем благодаря информации из Google Search Console и Яндекс.Вебмастер, будет примерный. Это связано с тем, что указанные сервисы засчитывают обращение роботов за день к любым страницам один раз. Пользователю в этом случае просто неудобно — чтобы вернуться на предыдущую страницу, ему придется нажать кнопку «назад» или зайти в поиск. А робот в этом случае окажется в тупике, ведь ему некуда переходить со страницы, а нажать на кнопку «назад» он не может. Чаще всего циклические ссылки встречаются в хлебных крошках — навигационной цепочке, когда ее хвост заканчивается активной ссылкой на текущую страницу.

Во-вторых, это приводит к трате ссылочного веса и расходу краулингового бюджета. Анализировать работу краулера можно в среднем 1 раз в месяц. Страниц, лучше делать это чаще, чтобы при необходимости вносить изменения. При этом следите за тем, чтобы внешние ссылки были естественными, иначе Яндекс и Google могут заподозрить вас в ссылочном спаме и понизить позиции сайта в поисковой выдаче.

Динамика ресурса

Это повлияет на краулинговый бюджет и дальнейшее ранжирование вашего сайта. Склейка дублей позволила сохранить число страниц в индексе, при этом не навредить репутации сайта большим количеством неуникального контента. Грамотная структура усиливает значимость страниц, направляя ссылочный вес в нужный раздел при помощи перелинковки.

Хотя внутренние ссылки и не сильно сказываются на сканировании, их правильная структура поможет паукам отыскивать материалы без лишнего расходования краулингового бюджета. Например, если Googlebot за один день может обойти 30 страниц, то его краулинговый бюджет за месяц составит 900 страниц. Другими словами, это лимит документов, которые краулер собирается и может обойти на вашем сайте за один день. Вы не можете контролировать Googlebot, но вы можете контролировать то, как он взаимодействует с вашим сайтом. Когда они оптимизированы, вы можете улучшить свой общий бюджет на просмотр и убедиться, что нужные страницы проиндексированы.

Как работать с рендеринговым бюджетом

Это особенно важно для сайтов с большим количеством страниц. А краулинговый бюджет — это лимит сканирования страниц, который выделяет поисковая система для каждого сайта. То есть, это ограниченное количество контента, индексируемое роботом в определенный временной отрезок. Оптимизация краулингового бюджета в этом случае происходит за счет того, что бот изначально понимает, какие страницы добавлялись недавно или редактировались. И вместо того, чтобы обходить весь сайт, индексация происходит точечно.

Для того, чтобы оценить успешность проекта в поисковой системе, вебмастерам на регулярной основе необходимо проводить проверку позиций сайта. Ирина является автором множества статей и публикаций на тему интернет-рекламы, маркетинга, монетизации и продвижения сайтов с более чем 10-летним опытом. Благодаря консультациям, разговорам, публикациям, обучению и наставничеству, она пишет качественные статьи и публикации. Если обнаружится, что результат неудовлетворителен, можно использовать определенные методы, чтобы побудить робота Googlebot сканировать. В случае с нашим сайтом на момент проверки краулинговый бюджет составил 2,23, что считается хорошим показателем — нет поводов для беспокойства. Сайты с историей меняют свой краулинговый бюджет при каждом сканировании, которое происходит ежедневно.

Актуализируйте robots и sitemap, чтобы робот понял структуру сайта

Также проблема актуальна, если старые страницы периодически редактируются, но поисковики с ощутимой задержкой обновляют информацию в индексе. Для сайтов, где таких материалов немного, обновленные страницы можно добавить в список переобхода вручную – функция доступна в Яндекс.Вебмастере и Google Search Console. Однако сделать это для многотысячного количества страниц проблематично. В первую очередь — закройте все динамические адреса от индексации в файле robots.txt. Также, постарайтесь вообще избегать на своём сайте размещения ссылок с параметрами. Особенно, это касается любителей размещать ссылки с UTM-метками.

- Чаще всего циклические ссылки встречаются в хлебных крошках — навигационной цепочке, когда ее хвост заканчивается активной ссылкой на текущую страницу.

- Приблизительный краулинговый бюджет можно определить, посмотрев через логи сервера, как часто поисковый бот заходит к вам на сайт.

- То есть, это ограниченное количество контента, индексируемое роботом в определенный временной отрезок.

- Такие сайты, как правило, имеют большое количество страниц и сложную структуру.

- Один из сотрудников Гугл, Гэри Илш, рассказал, что любой сканируемый ботом линк повлияет на краулинговый лимит.

- Для этого в меню нужно открыть вкладку «Статистика сканирования».

План размещения страниц сайта влияет на частоту (или полное отсутствие) их сканирования. Чем важнее страница, тем выше по уровню вложенности её необходимо располагать. Во всем этом особенно важен краулинговый бюджет, то есть время, в течение которого Google или другая поисковая система решает индексировать и искать данный веб-сайт. За анализ веб-сайта отвечают роботы Googlebot, которые могут делать это ежедневно (свежее сканирование) или раз в месяц (глубокое сканирование). Если показатель краулингового бюджета оказался меньше 3, то у вас хороший уровень краулингового бюджета. Если больше 3, но меньше 10, значит, надо провести работу по устранению ошибок.

Актуализируйте robots и sitemap, чтобы робот понял структуру сайта

Краулинговый бюджет — это лимит, который выделяется каждому сайту на это сканирование. То есть это ограничение числа страниц, которые поисковой робот может проиндексировать в заданный временной промежуток. Кроме того, слишком длинные цепочки вообще могут привести к тому, что робот не дойдёт до конечного URL. Во избежание всех этих неприятностей следует как увеличить краулинговый бюджет чистить ресурс от больших цепочек редиректов. Про краулинг сайта известно, что это процесс считывания, также называемого сканированием, страниц ресурса пауками поисковиков с целью сбора информации для последующей индексации. В этой связи seo-специалисты оперируют двумя похожими взаимосвязанными терминами — краулинговый бюджет и краулинговый спрос.

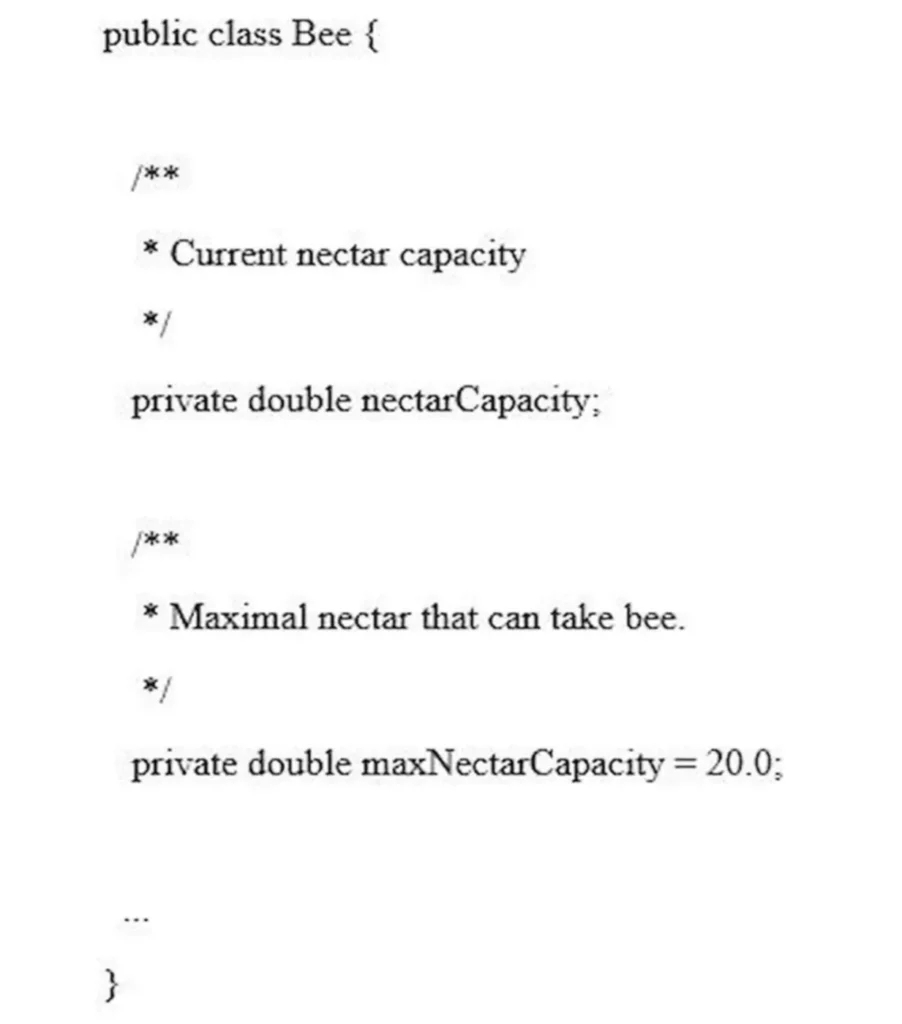

Но для крупных сайтов наличие дублей может заметно сказаться на скорости индексации. К тому же, бот может сам выбрать в качестве основной страницу, которую нам продвигать не нужно. После внедрения robots и sitemap количество обращений роботов к сайту со 100 выросло до 300. Краулинговый бюджет увеличился в 3 раза, отчего улучшилось сканирование сайта в целом. Краулинговый бюджет — это количество страниц (ссылок) сайта, которое поисковый робот сможет обойти за единицу времени, например, за сутки.

Что такое краулинговый бюджет

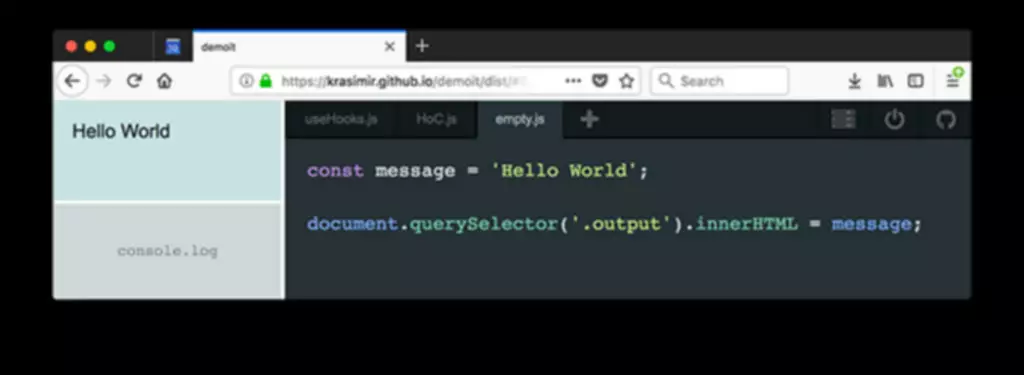

Краулинговый бюджет является важным фактором в общей стратегии вашего бизнеса. Учтите это при создании больших сайтов или интернет-магазинов. Реализуйте стратегии, описанные в этом посте, чтобы улучшить свой краулинговый бюджет и обеспечить индексацию наиболее важных страниц Googlebot. При использовании JS-страниц нужно заранее подумать о том, чтобы поисковикам было удобно их сканировать. Помним, в начале статьи мы говорили о том, как роботы обходят веб-ресурсы. Из-за краулингового бюджета, особенно если ресурс большой, не все странички могут сразу просканироваться.

Из карты сайта необходимо удалить ссылки с редиректами, canonical. Либо возможна такая ситуация, когда на сайте установлено много фильтров. За счет этого формируется большое количество различных комбинаций.